sgd目的是什么意思 (sdg 目标)

本文目录导航:

sgd目的是什么意思

SGD目的指的是随机梯度降低算法的运行成果评价目的。

接上去详细引见SGD:

一、SGD算法概述

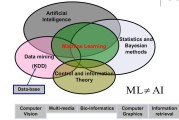

随机梯度降低是一种罕用的优化算法,用于在机器学习和深度学习中更新模型的参数,以最小化损失函数。

它在每次迭代时,只经常使用一个样本点启动梯度的计算和参数的更新,因此计算效率较高。

但在解决大规模数据集时,SGD或者由于其随机性而发生不稳固的收敛环节。

因此,对SGD算法的评价目的就成为了评价模型训练成果的关键规范。

二、SGD目的的解释

在评价SGD算法的运行成果时,通常会关注以下几个目的:

1. 收敛速度:这是权衡SGD算法效率的一个关键目的。

收敛速度越快,说明算法在相反期间内能够找到更优的解。

收敛速度遭到学习率、批量大小等起因的影响。

2.最优解的品质:该目的评价模型经过SGD优化后所能到达的最优解的品质。

优质的最优解象征着模型对训练数据的拟合水平好,并能有效地泛化到新的数据上。

3.稳固性:由于SGD算法的随机性,其在实践运行中的稳固性也是一个关键的评价目的。

稳固性好的算法能够在不同的数据集和性能下,体现出较为分歧的性能。

三、实践运行中的SGD目的关注点

在详细运行中,除了上述普通性的评价目的外,还须要关注与特定义务关系的目的,如分类准确率、回归义务的误差等,以片面评价SGD算法在该义务上的体现。

同时,针对特定模型和数据集的个性,或者还须要调整SGD的关系参数,以到达最佳的训练成果。

总结来说,SGD目的是用来评价随机梯度降低算法在机器学习模型训练环节中的体现成果的一系列评价规范,包含收敛速度、最优解的品质和稳固性等。

在实践运行中,还须要联合详细义务的需求和模型个性启动综合评价。

梯度降低法(SGD)原了解析及其改良优化算法

梯度降低法,简称SGD,是一种寻觅最小化目的函数的优化算法。

其外围现实是沿着函数的梯度方向逐渐调整参数,直到找到部分或全局最优解。

每次迭代中,咱们从以后位置登程,沿着以后梯度的负方向移动,直至到达必定水平的收敛或到达预设的中止条件。

以最小二乘误差(MSE)为例,目的是找到一组参数使误差最小化。

SGD的基本步骤包含:首先,计算目的函数对参数的梯度;而后,依据梯度调整参数值,通常驳回学习率来管理步长;当梯度的模(示意变动率)小于预设阈值时,中止迭代。

在泰勒级数倒退的基础上,SGD是对损失函数启动一阶近似并求解最小值,以此迭代更新参数。

在工程通常中,SGD存在噪声疑问,由于它或者在部分最优处徘徊。

批度降低法(BGD)与小批量随机梯度降低(SGD)的差异在于解决数据的方式,BGD解决整个训练集,而SGD每次只解决一部分。

选用适合的batch_size(如mini-batch)可以提高效率,减小噪声,使得模型收敛更快。

为了进一步优化SGD,发生了如Momentum(思考过去梯度动量)、Adagrad(自顺应学习率)、RMSProp(平滑梯度平方和)、Adadelta(灵活调整学习率)和Adam(联合动量和RMSProp的好处)等改良算法。

这些方法经过不同的机制,如动量调整、自顺应学习率计算等,有效优化SGD的性能和稳固性。

梯度降低法(SGD)原了解析及其改良优化算法

在机器学习的优化环节中,梯度降低法(SGD)犹如导航者,引领咱们沿着函数的峻峭降低路途,直至找到全局或部分最优解。

SGD的基本原理是应用函数梯度的负方向作为迭代更新的导向,以最小化损失函数J(θ)。

例如,当咱们经常使用均方误差(MSE)作为损失函数时,目的是寻觅使误差最小化的参数θ。

初始化后,经过求梯度并调整参数,直至到达预设的收敛阈值,这个环节就是泰勒倒退近似思维的通常。

面对多样化的选用,咱们有几种战略可供筛选:

在SGD的优化更新版中,咱们引入了愈加痴呆的战略:

速度变量的解决则更为巧妙,它经过指数加权平均方式 (1/(1-γ)),成功对过去梯度的延续调整。

每一种优化战略都在先人的基础上,以不同方式寻求最优的平衡,协助咱们在梯度降低的旅途中,走得更远,看得更清。

在实践运行中,选用最适合的优化算法,就像是在科技与艺术的交汇点,找到数据迷信的最优解。

文章评论