SGD 从 Adam 到

本文目录导航:

从 SGD 到 Adam —— 深度学习提升算法概览(一)

文章总结:

深度学习中的提升算法决定至关关键,本文旨在梳理从豪华的SGD到先进的Adam的演化环节,剖析各算法的优缺陷。

首先,SGD虽基础但易震荡,引入动量Momentum可减小震荡并减速收敛。

Nesterov Accelerated Gradient(NAG)则预测未来梯度,进一步提升。

Adagrad和RMSprop针对参数降级频率差异,经过自顺应学习率改善稠密数据功能。

Adam联合了RMSprop和Momentum的好处,而NAdam在此基础上融合了NAG的思维。

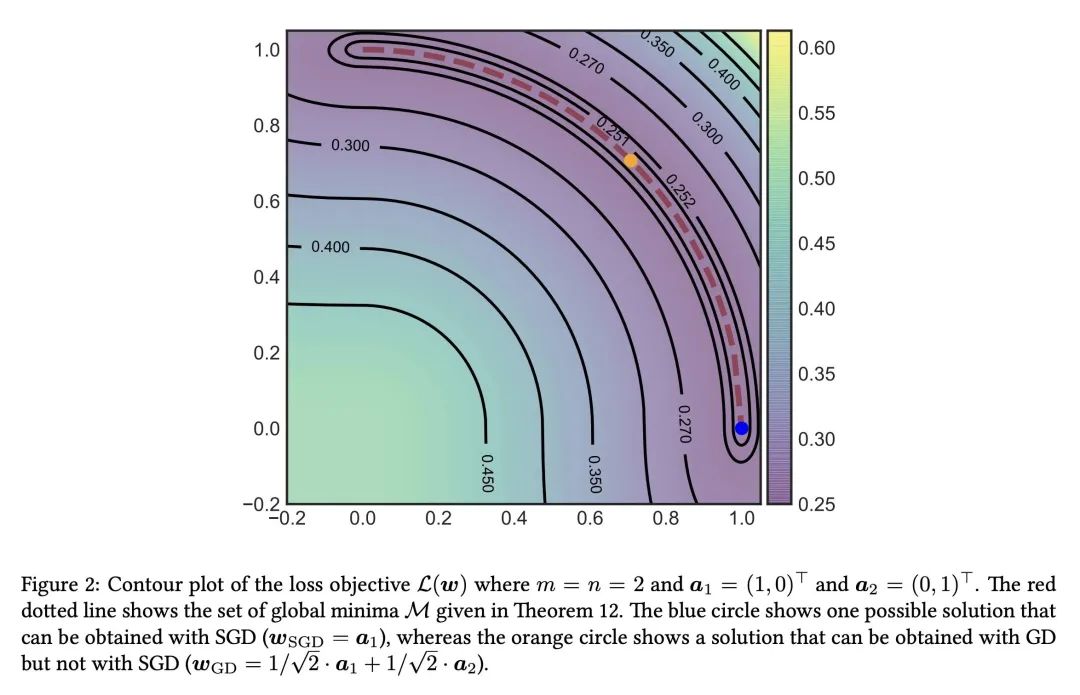

可视化剖析显示,Adagrad、Adadelta、RMSprop能极速收敛,而SGD-M和NAG在初始阶段或者偏离但最终也能找到正确方向。

自顺应算法在防止鞍点影响方面体现优于其余算法。

决定战略方面,虽然Adam广受欢迎,但在某些场景下,基础算法如SGD仍或者有其实用性。

深化了解提升算法关于模型训练至关关键,本文的剖析可作为进一步学习和通常的参考。

参考文献:

FM算法及其变形的通常引见和代码剖析

在深化讨论FM算法及其变形的通常引见和代码剖析之前,咱们先对这一系列文章的背景和目的启动简明引见。

这一专栏的第四篇文章旨在从通常与通常的角度,片面解析FM算法及其变形,包含各种算法的通常基础、提升战略、在线学习算法FTRL的浅析、以及不同变形算法如Field-aware FM、Attention FM、Field-weighted FM、Neural FM、Deep FM和DifaCTO算法的详细内容。

同时,将经过LIBFFM和DIFACTO两个算法库的引见,深化剖析算法的成功与代码通常。

无通常引见局部,首先回忆了罕用的提升算法,包含离线提升算法L-BFGS和用于处置L1正则的OWL-QN提升算法,以及在线提升算法FTRL的原理与运行。

接着详细论述了FM算法及其变形,如Field-aware FM引入了Field的概念,Attention FM经过引入Attention层辨别交叉特色的关键性,Field-weighted FM综合了Field和Attention的概念,Neural FM和Deep FM则在低阶特色的基础上引入高阶特色和非线性表白,增强模型的表白才干。

在代码剖析局部,将深化剖析LIBFFM,一个成功Field-aware FM模型的C++库,以及DIFACTO,一个基于Parameter Server (PS)的FM算法散布式成功库。

经过这些库的代码通常,了解算法的详细成功细节,包含参数降级、模型训练和提升环节,以及散布式环境下算法的裁减性与功能。

总结而言,经过本文的通常与通常剖析,读者将取得对FM算法及其变形的片面了解,包含它们的数学基础、提升战略和实践运行。

同时,经过LIBFFM和DIFACTO的代码通常,了解算法的成功细节,为实践名目中算法的决定与成功提供参考。

详细剖析如下:1. **L-BFGS与OWL-QN提升算法** - **L-BFGS提升算法**:经过回忆牛顿提升算法,引见了L-BFGS算法的设计指标,即在缩小计算量和存储量的同时近似拟合海森矩阵的逆,从而成功高效提升。

L-BFGS算法易于并行化,实用于大规模数据集。

- **OWL-QN提升算法**:为处置L1正则化疑问,OWL-QN算法经过引入伪梯度概念,处置了无法导点的提升疑问。

经过左右微分的计算公式,定义了伪梯度的决定规定,成功对L1正则化的提升。

2. **FTRL浅析** - **在线学习算法原理**:简述在线学习算法与离线学习的区别,强调在线学习算法在面对灵活数据散布时的顺应性和效率。

- **FTRL提升算法**:联合RDA算法的稠密性和FOBOS算法的精度,FTRL算法综合了稠密性和精度的好处。

经过初始化参数降级公式,展现了其如何在提升环节中坚持稠密性,缩小不用要的参数降级。

3. **FM算法及其变形提升** - **FM算法**:基于逻辑回归引入矩阵合成思维,FM算法在高维度稠密数据中体现出弱小的提升才干。

- **Field-aware FM**:经过引入Field的概念,针对相反畛域的特色启动学习,提高交叉特色的辨别度。

- **Attention FM**:在FM模型的基础上引入Attention层,灵活调整交叉特色的关键性,成功更精细的特色交互。

- **Field-weighted FM**:联合Field和Attention的概念,经过关联关键性调整不同畛域特色的交互权重。

- **Neural FM**和**Deep FM**:经过引入高阶特色交叉和非线性表白,增强模型的复杂度和表白才干,同时防止手工特色组合的繁琐环节。

4. **LIBFFM源码剖析** - **LIBFFM引见**:LIBFFM是对Field-aware FM模型的C++成功,提供详细的源码剖析,包含参数降级算法、模型训练环节和提升战略。

5. **DIFACTO源码剖析** - **DIFACTO引见**:DIFACTO基于Parameter Server (PS)成功的FM算法散布式库,提供单机多线程代码成功,引见关键类和程序逻辑结构。

经过以上剖析,读者将取得对FM算法及其变形的深化了解,包含通常基础、提升战略、代码成功和通常运行,为后续算法钻研与名目实施提供松软的通常与通常允许。

OpenAI自动算法-PPO:近端战略提升算法

论文《Proximal Policy Optimization Algorithms》提出了一种用于强化学习的新战略梯度方法,称为近端战略提升(PPO)。

与传统战略梯度方法相比,PPO在多个epoch中允许小批量降级,提高了数据效率和鲁棒性。

与信赖区域/人造战略梯度方法相比,PPO更易于成功,更通用,且在样本复杂性方面体现良好。

战略梯度方法经过计算战略梯度预计量并将其拔出随机梯度回升算法启动上班。

PPO驳回了一种简化代理指标,经过截断概率比来修正代替指标,以防止战略降级过大。

此指标包含未裁剪指标的下限,确保在概率比变动时只在改善指标时思考它。

此外,PPO经过KL处罚系数自顺应调整,以到达KL偏向的指标值。

试验结果标明,PPO在模拟机器人移动和玩Atari游戏等义务上优于其余在线战略梯度方法。

PPO在样本复杂性、便捷性和实践期间之间取得了无利平衡,证实了其在强化学习畛域的运行价值。

综上所述,近端战略提升(PPO)方法经过翻新性的代理指标和顺应性调零件制,成功了在强化学习畛域中的清楚提高。

其在多个义务上的低劣功能和良好的数据效率,使得PPO成为了以后强化学习钻研中的关键方法。

文章评论